2025.02.28

요약: 엔비디아 사장 젠슨항은 모든 핵심 기술 개발자, 모델 개발자, 그리고 소비자 대상 AI를 개발하는 기업들" 사이에서 AI 도입 속도가 "엄청나게 빠르다"고 설명하면서, "모두가" 인공지능 기술을 도입하기 위해 "경쟁하고 있다"고 말하면서

데이터 센터들이 사실상 'AI 공장'으로 탈바꿈하는 대규모 구축이 수년에 걸쳐 이러한 구축이 계속될 것이라고 말했다.

즉 엔비디아의 GPU 수요은 어마어마하다는 것을 강조하였다.

예를 들어 같은 용량의 데이터센터가 기존 GPU를 신규 GPU인 블랙웰로 교체할 경우 처리 용량이 4배,8배가 되므로,

매출이 4배 8배로 증가하므로 모두가 블랙웰을 채택하려고 한다는 것이다.

또 추론 모델(생각하는 인공 지능 모델,Inference)은 생성형 모델보다 100배 더 많은 컴퓨팅을 요구하므로,

데이터센터 수요는 더 증가할 수 밖에 없다.

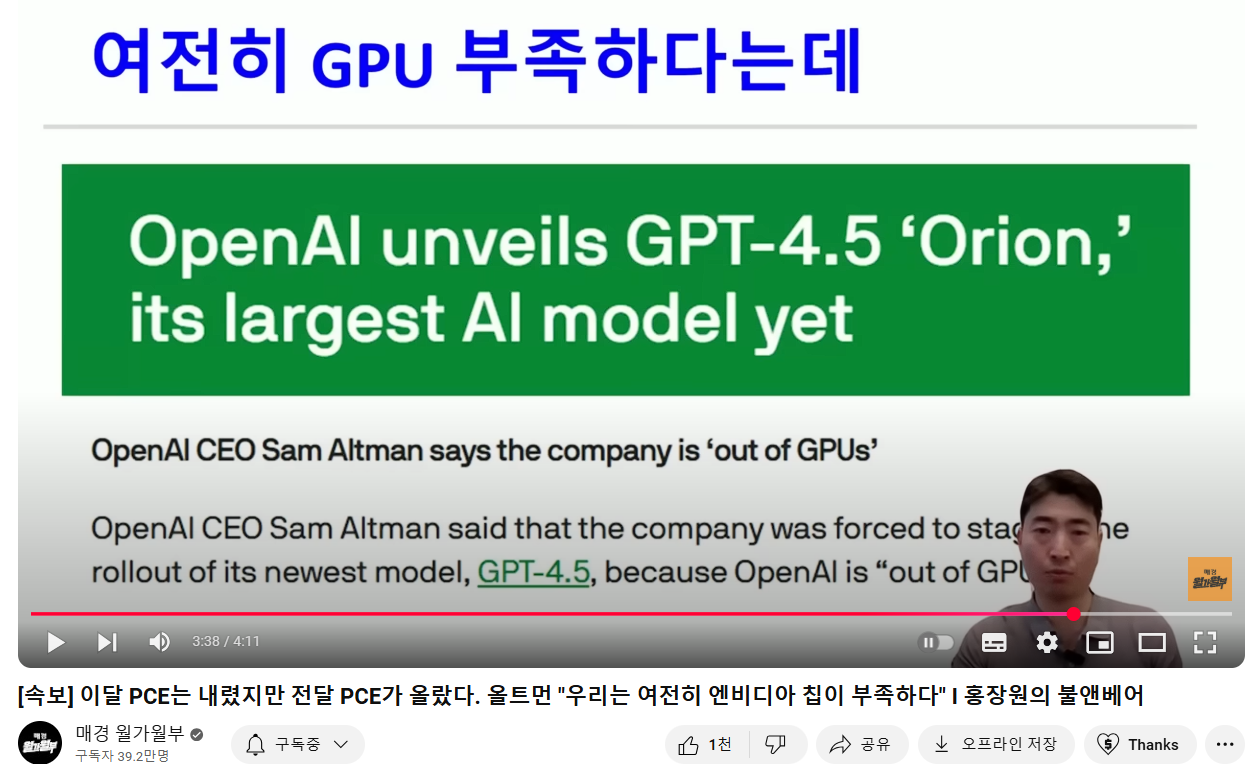

오픈AI의 샘올트만은 GPT4.5를 발표하면서 엔비디아의 GPU부족으로 일부 프로 사용자에게만

우선 공개한다고 하였고,아마존 CEO도 팟캐스팅 인터뷰에서 엔비디아 GPU 여전히 구하기가 어렵다고 말했다.

-------------------------------------------------

----------------------------------------------------------------------------------------------

2025.03.01

[속보] 이달 PCE는 내렸지만 전달 PCE가 올랐다. 올트먼 "우리는 여전히 엔비디아 칩이 부족하다" I 홍장원의 불앤베어

3분10초경:오픈AI의 샘올트만은 GPT4.5를 발표하면서 엔비디아의 GPU부족으로 일부 프로 사용자에게만

우선 공개한다고 하였고,아마존 CEO도 팟캐스팅 인터뷰에서 엔비디아 GPU 여전히 구하기가 어렵다고 말했다.

OpenAI CEO Sam Altman says the company is 'out of GPUs' | TechCrunch

OpenAI unveils GPT-4.5 ‘Orion,’ its largest AI model yet

OpenAI CEO Sam Altman says the company is ‘out of GPUs’

OpenAI CEO Sam Altman said that the company was forced to stage the rollout of its newest model, GPT-4.5, because OpenAI is “out of GPUs”

OpenAI, GPT-4.5 ‘Orion’ 공개 — 역대 최대 규모 AI 모델

OpenAI CEO 샘 알트먼, "GPU가 모자란 상황"이라고 밝혀

OpenAI CEO 샘 알트먼은, OpenAI가 최신 모델인 GPT-4.5의 출시를 단계적으로 진행할 수밖에 없었다며, 그 이유가 "GPU가 부족하기 때문"이라고 설명했습니다.

--------------------------------------------------

Nvidia CEO Jensen Huang says everyone is 'racing' to adopt AI technology

Nvidia CEO Jensen Huang says everyone is 'racing' to adopt AI technology

엔비디아 CEO 젠슨 황은 "모두가 AI 기술 도입 경쟁 중"이라고 말했다.

Nvidia CEO Jensen Huang discussed artificial intelligence (AI) and more in an interview with Liz Claman on "The Claman Countdown." Huang, who co-founded the California-based chipmaker in 1993, told Claman that "everybody" is "racing" to adopt artificial intelligence technology. Adoption is "incredibly fast" among what the Nvidia CEO described as the "core technology builders, the model builders and the companies that are building consumer-oriented AIs."

엔비디아의 CEO인 젠슨 황은 "클라만 카운트다운"에서 리즈 클라만과의 인터뷰에서 인공지능(AI)과 기타 주제에 대해 이야기했습니다.

1993년에 캘리포니아에 기반을 둔 이 반도체 회사를 공동 창업한 황은, "모두가" 인공지능 기술을 도입하기 위해 "경쟁하고 있다"고 클라만에게 말했습니다.

황은 특히 "핵심 기술 개발자, 모델 개발자, 그리고 소비자 대상 AI를 개발하는 기업들" 사이에서 AI 도입 속도가 "엄청나게 빠르다"고 설명했습니다.

"The frontier models, and all of the startups trying to build a next-generation of frontier models, they’re racing to get to the next level," he added. Agentic AI is "developing very nicely" and "likely to come on next," according to Huang. He said the next phase after that would be physical AI.

황은 "최전선 모델들과, 그리고 차세대 최전선 모델을 만들기 위해 노력하는 모든 스타트업들이 다음 단계로 나아가기 위해 경쟁하고 있다"고 덧붙였습니다.

그는 에이전틱 AI가 "매우 순조롭게 발전하고 있으며" "다음으로 등장할 가능성이 높다"고 말했습니다. 그 다음 단계는 물리적 AI가 될 것이라고 황은 설명했습니다.

"This is AI that understands the laws of the physical world. It understands things like inertia and gravity and cause and effect and object permanence, and we’ll use that for self-driving cars and robotics systems and things of that nature," he explained.

그는 "이것은 물리적 세계의 법칙을 이해하는 AI입니다. 관성, 중력, 인과관계, 그리고 물체 영속성 같은 개념을 이해하는 AI로, 자율주행 자동차나 로봇 시스템 같은 것들에 활용될 것입니다"라고 설명했습니다.

Huang said such industries "are kind of coming on in waves" and "building on top of each other." Meanwhile, on the topic of data centers, he said capital expenditures are showing "huge growth" in comparison to last year.

황은 이러한 산업들이 "일종의 물결처럼 순차적으로 등장하고 있으며" "서로 위에 쌓아가고 있다"고 말했습니다.

한편, 데이터 센터와 관련해서는, 자본 지출이 작년과 비교해 "엄청난 성장"을 보이고 있다고 언급했습니다.

"Not only is the capex larger, the amount of that capex dedicated to AI is going to be far greater," the Nvidia CEO said during the interview. "We’re seeing a very robust growth for this year compared to last year, and I think we’re teed up for some pretty great build outs of these data centers to produce essentially what I call AI factories, which in the future will transform energy, if you will, into digital intelligence… We’ve got several years, many years of build out to go."

황은 인터뷰에서 "자본 지출 규모가 커졌을 뿐만 아니라, 그 중 AI에 할당되는 비중이 훨씬 더 커질 것"이라고 말했습니다. "올해는 작년과 비교해 매우 강한 성장이 나타나고 있고, 앞으로 저는 이 데이터 센터들이 사실상 'AI 공장'으로 탈바꿈하는 대규모 구축이 이루어질 것으로 보고 있습니다. 이는 궁극적으로 에너지를 디지털 지능으로 변환하는 역할을 할 것입니다… 앞으로 몇 년, 아니 수년에 걸쳐 이러한 구축이 계속될 것입니다."

Huang also discussed DeepSeek, a Chinese startup that released models that it claimed are comparable to leading U.S. ones at a much cheaper cost, and how its technology has affected AI and Nvidia. The startup has "opened up reasoning AI" and "opened up a whole new field that consumes an enormous amount" of Nvidia’s computing capability, with many AI developers making use of the new types of models.

황은 또한 중국 스타트업 딥시크(DeepSeek)에 대해서도 언급했습니다. 이 회사는 자사가 출시한 모델들이 미국의 선도 모델들과 견줄 수 있으면서도 훨씬 저렴한 비용으로 제공된다고 주장했으며, 이 기술이 AI와 엔비디아에 미친 영향에 대해서도 설명했습니다.

황은 딥시크가 "추론 AI의 문을 열었으며" "엔비디아의 엄청난 컴퓨팅 능력을 소비하는 완전히 새로운 분야를 열었다"고 말했습니다. 또한 많은 AI 개발자들이 이러한 새로운 유형의 모델을 활용하고 있다고 덧붙였습니다.

The new generation of AI models has "caused demand to be really high," he said.

그는 "새로운 세대의 AI 모델들이 등장하면서 수요가 정말 크게 증가했다"고 말했다.

Nvidia Sales Spike On Ai Demand During the interview, Huang also weighed in on the sit-down he had with President Donald Trump in late January. The U.S. currently has multiple semiconductor chip controls for exports to China. Huang told Claman that Nvidia is "committed and very enthusiastic to work with the Trump administration to achieve its goals and want the administration to succeed."

엔비디아, AI 수요로 매출 급증

인터뷰에서 황은 지난 1월 말에 도널드 트럼프 전 대통령과 만났던 자리에서도 어떤 이야기가 오갔는지 언급했습니다. 현재 미국은 중국으로의 반도체 칩 수출을 여러 규제로 통제하고 있습니다.

황은 클라만에게 "엔비디아는 트럼프 행정부와 함께 목표를 달성하기 위해 적극적으로 협력할 준비가 되어 있으며, 행정부가 성공하길 진심으로 바란다"고 말했습니다.

"But the net of it all is, if you look at where Nvidia’s computers are that are going to China today and you compare it against what we just launched this quarter, this record-breaking quarter that we had with Grace Blackwell, the comparison of the technology, anywhere from 20 to 60 times higher performance is what we currently have in the United States, and so every day that goes by, the export-controlled technology is further and further behind, if you will, in a lot of ways. It’s another way of saying every day that goes by we’re making that technology slower and slower," he continued. "So I think the conversation is good, and we’re happy to share with the administration everything we know, so they can make the best decision."

“하지만 전체적인 결론은 이렇습니다. 현재 중국으로 수출되는 엔비디아의 컴퓨터와, 이번 분기에 출시한 그레이스 블랙웰(Grace Blackwell) 제품을 비교해보면, 이번 분기 실적이 역대 최고를 기록했을 정도로, 기술 성능 차이가 20배에서 최대 60배까지 납니다. 즉, 시간이 지날수록 수출 통제 대상 기술은 점점 더 뒤처지고 있습니다.”

그는 이어서 “다르게 말하면, 우리는 매일매일 그 기술을 더 느리게 만들고 있는 셈입니다. 그래서 저는 이런 대화 자체는 굉장히 의미 있다고 생각하고, 우리가 알고 있는 모든 정보를 행정부와 기꺼이 공유할 준비가 되어 있습니다. 그렇게 해야 행정부도 가장 좋은 결정을 내릴 수 있을 테니까요.”라고 말했습니다.

The company generated $39.3 billion in revenue during the three-month period, marking a 78% increase from the same quarter last year. Its net income, meanwhile, came in at nearly $22.1 billion, an 80% year-over-year jump. Nvidia’s market capitalization hovered around $2.94 trillion as of Thursday./

회사는 이번 분기 동안 393억 달러의 매출을 기록했으며, 이는 전년 같은 분기 대비 78% 증가한 수치입니다.

한편, 순이익은 약 221억 달러로, 전년 대비 80% 증가했습니다.

엔비디아의 시가총액은 목요일 기준 약 2.94조 달러 수준을 기록했습니다.

----------------------------------

Nvidia (NVDA) CEO Jensen Huang took to the company’s fourth quarter earnings call on Wednesday, looking to reaffirm the chip giant’s place in the AI trade — and calm Wall Street jitters around the technology’s future growth. Shares of Nvidia were off more than 7% on the year going into Wednesday’s print as investors and analysts raised questions about Big Tech’s continued AI spending. The stock sank 8% by the close of trading on Thursday as those doubts persisted.

엔비디아(NVDA)의 CEO 젠슨 황은 수요일에 열린 회사의 4분기 실적 발표 컨퍼런스 콜에서, 엔비디아가 AI 시장에서 여전히 핵심적인 위치를 차지하고 있음을 강조하며, AI의 미래 성장성에 대한 월가의 우려를 잠재우려 했습니다.

수요일 실적 발표 전까지 엔비디아 주가는 올해 들어 7% 이상 하락한 상태였으며, 투자자들과 애널리스트들은 빅테크의 AI 투자 지속 여부에 대해 의문을 제기하고 있었습니다. 이러한 불안감이 이어지면서, 엔비디아 주가는 목요일 장 마감 기준으로 8% 하락했습니다.

The fears: That the rise of DeepSeek’s AI models meant developers didn’t need to use pricey chips like Nvidia’s Blackwell GPUs — and that custom chips developed by Nvidia customers like Amazon (AMZN) and Google (GOOG, GOOGL) could threaten the company’s long-term health. Huang held off on making opening remarks during Nvidia’s call. Instead, he answered analysts’ questions throughout and closed with comments explaining how models like DeepSeek’s will require even more power than earlier models. When DeepSeek debuted its R-1 model in January, it sent AI stocks into a tailspin. That’s because the company says it developed the software, which rivals OpenAI’s platform, using Nvidia’s H20 chips. Those processors are far less powerful than the AI titan’s Blackwell chips, leading investors to question whether Nvidia was facing an existential crisis. After all, if companies could create AI platforms using more affordable chips, why would they need to spend billions on Nvidia’s high-end processors?

우려의 핵심은 다음과 같습니다. 딥시크(DeepSeek)의 AI 모델이 부상하면서, 개발자들이 엔비디아의 고가 GPU인 블랙웰(Blackwell) 칩을 꼭 사용할 필요가 없어지는 것 아니냐는 점입니다. 또한, 아마존(AMZN)과 구글(GOOG, GOOGL) 같은 엔비디아 고객들이 자체 맞춤형 칩을 개발하면서, 장기적으로 엔비디아의 사업이 위협받을 수 있다는 걱정도 커졌습니다.

황은 이번 컨퍼런스 콜에서 별도의 오프닝 발언 없이, 애널리스트들의 질문에 직접 답변하는 형식으로 진행했습니다. 그는 마무리 발언에서, 딥시크 같은 모델일수록 이전 모델보다 훨씬 더 많은 컴퓨팅 파워가 필요하다고 설명하며 우려를 진정시키려 했습니다.

딥시크는 지난 1월 R-1 모델을 공개했을 때, AI 관련 주식들이 일제히 급락하는 상황을 불러왔습니다.

딥시크가 엔비디아의 최상위 블랙웰 칩이 아닌, 상대적으로 성능이 낮은 H20 칩으로도 오픈AI와 경쟁할 수 있는 소프트웨어를 개발했다고 밝혔기 때문입니다. 이 소식은 "굳이 엔비디아의 고가 프로세서를 사야 할 이유가 없어지는 것 아니냐"는 의문을 투자자들 사이에서 불러일으키며, 엔비디아의 존재 자체가 위협받을 수 있다는 우려로 이어졌습니다.

Huang, however, explained that because DeepSeek’s model, and others like it, provided better responses when using more powerful AI chips, Nvidia will continue to benefit from their use.

하지만 황은 딥시크 모델을 비롯한 유사한 모델들이 더 강력한 AI 칩을 사용할수록 더 나은 응답을 제공하기 때문에, 결국 엔비디아는 계속해서 수혜를 입을 것이라고 설명했습니다.

“The more the model thinks the smarter the answer. Models like OpenAI, Grok 3, DeepSeek-R1 are reasoning models that apply inference time scaling,” Huang said. “Reasoning models can consume 100x more compute. Future reasoning models can consume much more compute."

황은 이렇게 말했습니다.

“모델이 더 깊이 생각할수록 더 스마트한 답변을 제공합니다. OpenAI, Grok 3, DeepSeek-R1 같은 모델들은 추론 시간 스케일링을 적용하는 '추론형(reasoning) 모델'입니다. 이런 모델들은 기존보다 100배 더 많은 연산을 필요로 합니다. 앞으로 등장할 추론형 모델들은 훨씬 더 많은 연산을 요구할 것입니다.”

Huang also explained that models like DeepSeek are driving demand for inferencing, the process of running AI applications.

또한 황은 딥시크 같은 모델들이 AI 애플리케이션을 실제로 실행하는 과정인 ‘추론(Inferencing)’ 수요를 이끌고 있다고 설명했습니다.

Training AI models requires a massive amount of power and performance. But as inferencing becomes the main use case for AI systems, Wall Street investors have questioned whether Nvidia’s customers will opt for cheaper, less powerful chips. Huang, however, contends that DeepSeek’s models, and those like them, illustrate that inferencing will require plenty of power in their own right.

AI 모델을 학습시키는 과정에서는 엄청난 전력과 성능이 필요하지만, 이제는 학습보다 추론이 AI 시스템의 주요 사용 사례가 되고 있습니다. 이 때문에 월가 투자자들 사이에서는 엔비디아 고객들이 더 저렴하고 성능이 낮은 칩으로 전환할 가능성에 대한 우려가 제기되어 왔습니다.

그러나 황은 딥시크 같은 모델들이 오히려 추론 과정에서도 막대한 연산 성능이 필요하다는 점을 보여주고 있다고 강조했습니다.

( Inference time scaling은 AI 분야에서 최근 많이 언급되는 개념인데, 쉽게 말하면 AI 모델이 정답(또는 응답)을 생성할 때, 더 오래 생각하고 더 많은 계산을 수행할수록 더 똑똑한 답변을 낼 수 있다는 원리를 의미합니다.

좀 더 풀어서 설명하자면:

- 기존에는 AI 모델이 훈련(training) 과정에서만 많은 계산이 필요하고, 실제 서비스할 때(추론·inference 단계)는 상대적으로 적은 계산 자원으로 빠르게 답을 내는 방식이 일반적이었어요.

- 그런데 최근 등장하는 최신 AI 모델들(예: OpenAI GPT-4, Grok 3, DeepSeek-R1 등)은 “추론 시간”을 더 길게 잡고, 그 시간 동안 더 깊이 생각하고 계산하는 방식을 택하고 있어요.

- 즉, "빠른 답변"보다 "더 똑똑한 답변"을 목표로 하는 흐름인 거죠.

- 이 과정에서 모델이 스스로 다양한 가능성을 더 많이 시뮬레이션하고, 그 결과 더 많은 연산 자원과 시간이 필요하게 됩니다.

비유로 설명하면:

과거에는 문제를 보면 바로 찍듯이 대충 답을 내는 방식이었다면,

이제는 문제를 보고, 이것저것 생각해보고, 관련 지식까지 더 찾아본 뒤, 신중하게 답을 내는 방식으로 진화하고 있다는 거예요.

당연히 이런 방식은 더 강력한 GPU와 더 긴 계산 시간이 필요합니다.

요점 정리

구분예전 방식최신 방식 (Inference time scaling 적용)

| 추론 속도 | 빠름 | 느림 (더 깊이 생각) |

| 필요 계산량 | 적음 | 많음 (100배 이상) |

| 결과 품질 | 비교적 단순한 답 | 더 정교하고 똑똑한 답 |

이런 흐름 덕분에 엔비디아 같은 고성능 GPU 업체들은 계속 중요한 역할을 하게 될 거라고 젠슨 황이 강조한 거죠.

)

ASICs and the move to consumer AI ASICs와 소비자용 AI로의 이동

In addition to addressing DeepSeek, Huang also hit on the impact of ASICs on the industry — and what it could mean for Nvidia.

딥시크(DeepSeek)에 대한 언급과 함께, 황 CEO는 ASIC이 업계에 미치는 영향과 그것이 엔비디아에 어떤 의미를 갖는지도 짚었습니다.

ASICs or application-specific integrated circuits, are chips designed specifically for, as you might guess, specific applications.

ASIC(Application-Specific Integrated Circuits)이란, 이름 그대로 특정 용도에 맞춰 설계된 맞춤형 칩을 의미합니다.

Google used its Tensor Processing Unit, which is an ASIC, to train its Gemini AI platform. In Huang's estimation, Nvidia’s chips offer 2x to 8x better performance per watt than ASICs and can be used across various AI applications because they’re built for general-purpose computing and have a large software ecosystem that customers can rely on.

구글은 자사의 ASIC인 TPU(Tensor Processing Unit)를 사용해 제미니(Gemini) AI 플랫폼을 학습시켰습니다.

황의 평가에 따르면, 엔비디아의 칩은 ASIC보다 **전력당 성능(performance per watt)**이 2배에서 8배 더 뛰어나며, 다양한 AI 애플리케이션에 폭넓게 사용할 수 있습니다.

이는 엔비디아의 칩이 범용 컴퓨팅(general-purpose computing)에 최적화되어 있고, 고객들이 신뢰할 수 있는 방대한 소프트웨어 생태계를 갖추고 있기 때문이라고 설명했습니다.

“There's a lot of different reasons why we do well, why we win,” Huang said. What’s more, the CEO said that just because an ASIC is built doesn’t mean it will be deployed. “There are a lot of chips that get built, but when the time comes, a business decision has to be made, and that business decision is about deploying a new engine, a new processor into a limited AI factory in size, in power,” he explained.

황은 이렇게 말했습니다.

"엔비디아가 잘 나가는 이유, 우리가 승리하는 이유는 여러 가지가 있습니다."

더불어 황은 ASIC이 만들어졌다고 해서 반드시 실제로 쓰이는 것은 아니라고 강조했습니다.

그는 이렇게 덧붙였습니다.

“만들어진 칩은 많지만, 실제로 AI 팩토리에 투입할 때는 비즈니스적인 판단이 필요합니다.

그 판단은 결국 한정된 공장 공간과 전력 안에서, 새로운 엔진과 프로세서를 배치할 것인가라는 문제로 귀결됩니다.”

Beyond ASICs, Huang hit on the larger issue of whether Nvidia can grow beyond its heavy reliance on cloud service providers. Currently, CSPs make up 50% of Nvidia’s data center sales. And if those customers continue to develop their own ASICs and end up relying on them, Nvidia risks losing a key source of revenue. But Huang said the company has far more options in front of it. “We've really only tapped consumer AI and search and some amount of consumer generative AI, advertising, recommenders … the next wave is coming,” he explained.

ASIC 이야기를 넘어서, 황은 엔비디아가 현재처럼 **클라우드 서비스 제공업체(CSP)**에 지나치게 의존하는 구조에서 벗어나 성장할 수 있을지에 대한 더 큰 문제도 언급했습니다.

현재 엔비디아의 데이터센터 매출 중 약 50%가 CSP에서 나오고 있습니다. 만약 이 고객들이 자체 ASIC을 계속 개발해 그쪽으로 의존도를 높인다면, 엔비디아는 핵심 매출원을 잃을 위험에 처할 수 있습니다.

하지만 황은, 엔비디아 앞에는 훨씬 더 많은 기회가 열려 있다고 강조했습니다.

그는 이렇게 설명했습니다.

"우리는 이제 막 소비자 AI, 검색, 일부 생성형 AI, 광고, 추천 시스템 같은 영역을 건드리기 시작한 단계입니다. 그리고 다음 물결이 곧 밀려옵니다."

“Agentic AI for enterprise, physical AI for robotics, and sovereign AI … each one of these are barely off the ground, and we can see them. We can see great activity happening in all these different places and these will happen,” Huang added.

황은 이어서 이렇게 덧붙였습니다.

"기업용 에이전틱 AI(Agentic AI for enterprise), 로봇용 물리적 AI(Physical AI for robotics), 주권 AI(Sovereign AI) … 이 모든 분야는 이제 막 시작 단계일 뿐이지만, 우리는 이 흐름을 분명히 보고 있습니다. 이미 각 분야에서 활발한 움직임이 일어나고 있고, 이 흐름은 현실이 될 것입니다."

The upshot: Nvidia sees more use cases for its chips beyond being power plants for Amazon, Google, Meta, and Microsoft. Up next, the company will host its GTC conference on March 18, when it’s expected to launch its Blackwell Ultra chip and provide details about its next-generation Vera Rubin processor.

결론적으로, 엔비디아는 자사 칩이 아마존, 구글, 메타, 마이크로소프트 같은 대형 클라우드 업체들의 'AI 연산의 동력원'

역할을 넘어, 훨씬 더 폭넓은 활용처를 갖게 될 것으로 기대하고 있습니다.

다음으로 엔비디아는 오는 3월 18일 GTC 컨퍼런스를 개최할 예정이며, 이 자리에서 블랙웰 울트라(Blackwell Ultra) 칩을 공개하고, 차세대 프로세서인 **베라 루빈(Vera Rubin)**에 대한 정보도 함께 발표할 것으로 예상됩니다.

'엔비디아-마이크로소프트-AMD-인텔' 카테고리의 다른 글

| 모건스탠리,엔비디아 목표가 162달러로 상향(2025.03.04) (0) | 2025.03.04 |

|---|---|

| AMD RDNA 4와 Radeon RX 9000 시리즈 GPU, 549달러부터 시작(2025.03.02) (0) | 2025.03.02 |

| 엔비디아 '25년4분기 실적 발표-긍정적(2025.02.27) (1) | 2025.02.27 |

| 엔비디아 CEO 젠슨 황은 딥시크(DeepSeek)에 대해 어떻게 생각하는가(2025.02.22) (0) | 2025.02.22 |

| AI 서버 수요 증가로 성장하는 엔비디아, 경쟁 우위 확보(2025.02.11) (0) | 2025.02.12 |