2026.01.19

Redefining Secure AI Infrastructure with NVIDIA BlueField Astra for NVIDIA Vera Rubin NVL72 | NVIDIA Technical Blog

Large-scale AI innovation is driving unprecedented demand for accelerated computing infrastructure. Training trillion-parameter foundation models, serving them with disaggregated architectures…

developer.nvidia.com

NVIDIA BlueField Astra란 무엇인가?

CES 2026에서 발표된 바와 같이, NVIDIA의 Rubin 플랫폼에는 BlueField-4에서 구동되는 새로운 **BlueField Advanced Secure Trusted Resource Architecture(Astra)**가 도입되었습니다.

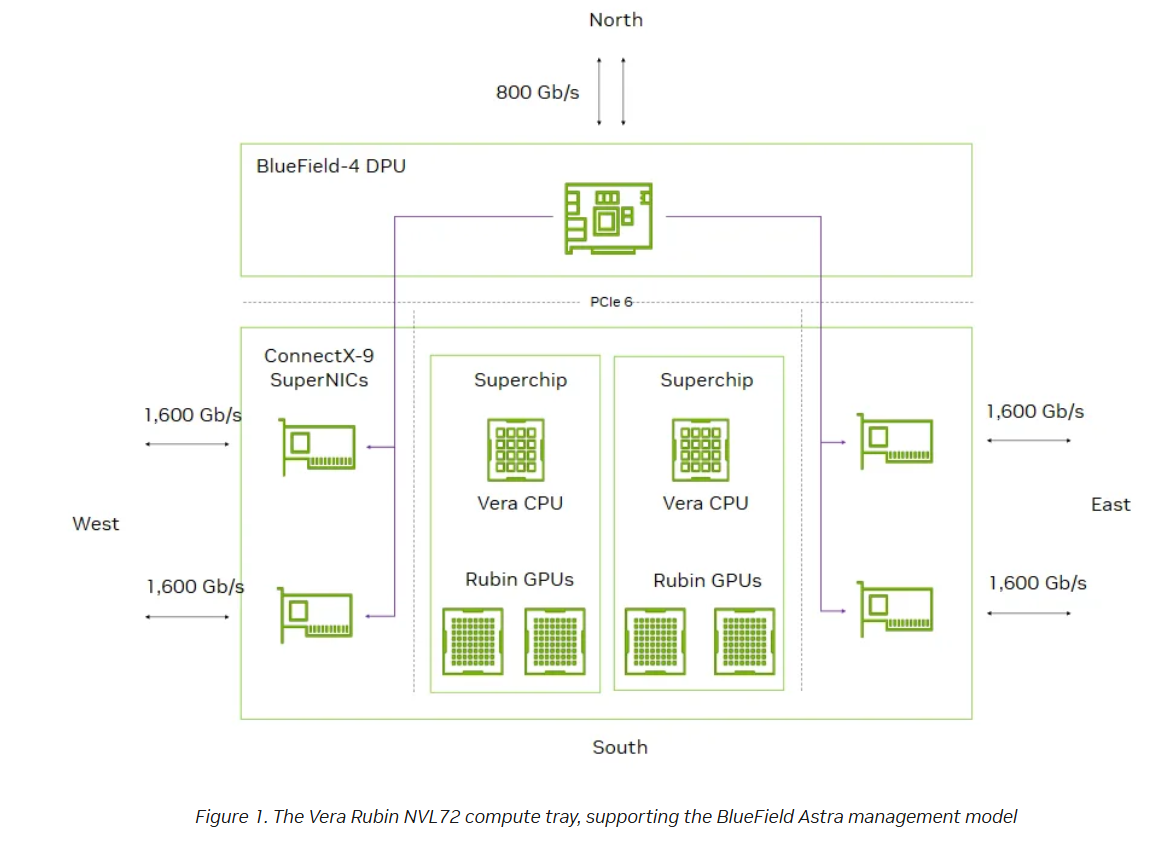

BlueField Astra는 하드웨어와 소프트웨어 혁신을 결합한 획기적인 시스템 수준 아키텍처로, NVIDIA Vera Rubin NVL72 컴퓨트 트레이와 깊이 있게 통합되어 있습니다.

BlueField-4 DPU와 NVIDIA ConnectX-9 SuperNIC 간의 전용 연결을 통해, BlueField Astra는 관리, 프로비저닝, 정책 집행 기능을 동서(E-W) 패브릭 전반으로 확장합니다. 이는 DPU가 컴퓨트 노드로 들어오고 나가는 모든 네트워크 I/O를 제어하는 구조가 처음으로 구현되었음을 의미합니다.

(주: DPU(Data Processing Unit)는 데이터센터에서 네트워크·보안·스토리지·인프라 관리 같은 작업을

CPU 대신 전담 처리하도록 설계된 전용 프로세서입니다.

쉽게 말해, CPU가 하던 ‘인프라 운영 업무’를 떼어내어 맡기는 관리·제어 전용 두뇌입니다.)

BlueField Astra를 통해 CSP들은 BlueField-4 DPU에서 실행되는 신뢰 가능한 소프트웨어 스택을 확장하여,

AI 컴퓨트 패브릭 전반에서 테넌트 격리와 네트워크 정책을 안전하게 관리할 수 있습니다.

이러한 정책은 아웃오브밴드 DPU 포트를 통해 프로그래밍되며, SuperNIC 하드웨어에서 직접 집행되어 시스템 전체에 걸쳐 일관된 제어를 보장합니다.

BlueField Astra의 핵심에는 새로운 제어 플레인 아키텍처가 있습니다. 기존처럼 호스트 기반 소프트웨어가 NIC와 패브릭을 함께 설정하는 방식과 달리, BlueField Astra는 SuperNIC의 제어 플레인을 호스트 운영체제로부터 완전히 분리합니다.

그 결과, 베어메탈 환경에서 실행되는 테넌트 워크로드조차도 네트워크 프로비저닝을 훼손하거나 이에 접근해 내용을 파악하는 것이 불가능해집니다.

As shown in Figure 1, BlueField Astra establishes a direct path between the BlueField-4 DPU and ConnectX-9 SuperNICs, creating a unified control architecture. This delivers:

그림 1에서 보듯이, BlueField Astra는 BlueField-4 DPU와 ConnectX-9 SuperNIC 사이에 직접적인 경로를 구축함으로써

통합된 제어 아키텍처를 형성합니다. 이를 통해 다음과 같은 핵심 기능이 제공됩니다.

- Dedicated connectivity: Each NVIDIA ConnectX-9 SuperNIC connects directly to the BlueField-4 DPU, enabling the DPU to program, configure, and monitor the SuperNIC without relying on the host CPU.

우선, 전용 연결 구조가 구현됩니다. 각 NVIDIA ConnectX-9 SuperNIC는 BlueField-4 DPU에 직접 연결되며, 이를 통해 호스트 CPU에 의존하지 않고도 DPU가 SuperNIC을 직접 프로그래밍하고 설정하며 상태를 모니터링할 수 있습니다. - Out-of-band control: BlueField Astra routes all provisioning instructions and network policies through the BlueField embedded Arm cores.

또한 아웃오브밴드 제어 방식을 채택하고 있습니다. 모든 프로비저닝 지시와 네트워크 정책은 BlueField에 내장된 Arm 코어를 통해 전달되며, 호스트 시스템과 완전히 분리된 경로로 관리됩니다. - Unified control of N-S and E-W: BlueField-4 consolidates both domains under a single trusted control point. The same DPU that manages N-S networking for tenant isolation and security policies now extends those capabilities into the E-W AI compute fabric.

BlueField Astra는 N-S(남북) 트래픽과 E-W(동서) 트래픽을 단일 제어 지점에서 통합 관리합니다. 테넌트 격리와 보안 정책을 위해 N-S 네트워킹을 담당하던 동일한 BlueField-4 DPU가, 이제 그 제어 범위를 E-W AI 컴퓨트 패브릭까지 확장하는 구조입니다. - Isolation from the tenant: Tenants use the SuperNIC for AI data movement, but have no access to or control over management functions, which remain fully isolated on the DPU.

이와 함께 테넌트로부터의 완전한 격리가 보장됩니다. 테넌트는 AI 데이터 이동을 위해 SuperNIC을 사용하지만, 관리 기능에는 접근하거나 이를 제어할 수 없으며, 이러한 기능은 전부 DPU 상에서 완전히 분리되어 유지됩니다. - Security model consistency: By moving the NVIDIA DOCA stack from the host to the DPU, BlueField Astra ensures the E-W fabric inherits the same cloud-aligned security posture already proven for N-S traffic.

마지막으로, 보안 모델의 일관성이 확보됩니다. NVIDIA DOCA 스택을 호스트에서 DPU로 이전함으로써, BlueField Astra는 이미 N-S 트래픽에서 검증된 클라우드 수준의 보안 체계를 E-W 패브릭에도 그대로 적용할 수 있게 합니다.

BlueField Astra enables control, consistency, and confidence

BlueField Astra는 제어, 일관성, 그리고 신뢰를 제공합니다

BlueField Astra는 N-S(남북)와 E-W(동서) 도메인을 아우르는 통합 제어 플레인을 구축함으로써 AI 인프라 관리 방식을 근본적으로 변화시킵니다. BlueField-4 DPU에 단일 제어 지점을 두는 구조를 통해, 서비스 제공자는 호스트 CPU를 전혀 건드리지 않고도 프로비저닝을 간소화하고, 정책을 일관되게 집행하며, 운영 복잡성을 크게 낮출 수 있습니다.

설계 단계부터 BlueField Astra는 더 강력한 격리와 보안을 제공하도록 만들어졌습니다. SuperNIC의 제어 플레인은 테넌트 워크로드와 완전히 분리되어 DPU에서 전담 관리되며, 그 결과 테넌트는 어떤 방식으로도 정책을 우회하거나 변경할 수 없습니다.

이러한 구조는 횡적 이동(lateral movement)과 설정 드리프트(configuration drift)를 방지하고, CSP가 멀티테넌트 환경에서도 베어메탈 GPU 노드를 안전하게 제공할 수 있다는 확신을 갖게 합니다.

또한 BlueField Astra는 운영 측면에서의 일관성을 강화합니다. 서비스 제공자는 이미 N-S 프런트엔드에서 사용 중인 DOCA 기반 관리 도구와 워크플로를 그대로 E-W 컴퓨트 패브릭까지 확장할 수 있습니다.

정책은 SuperNIC 하드웨어 단까지 내려가 직접 집행되며, 이를 통해 테넌트 인지형의 세밀한 프로비저닝이 가능해지는 동시에, NVIDIA SuperNIC이 갖는 고성능 특성도 그대로 유지됩니다.

마지막으로 BlueField Astra는 규제 대응과 감사 가능성까지 지원합니다. 정책과 설정이 호스트가 아니라 DPU에 상주함으로써, CSP는 보다 명확한 감사 추적 경로를 확보할 수 있고, 규제 산업이 요구하는 보안 기준에 부합하는 보안 태세를 유지할 수 있습니다.

이는 보안을 사후적으로 덧붙이는 방식이 아니라, 대규모 AI 인프라의 운영 체계 자체에 보안을 내재화했다는 점에서 중요한 의미를 가집니다.

베어메탈 AI 시스템으로 확장되는 운영 워크플로

BlueField Astra는 DOCA 소프트웨어 플랫폼을 기반으로, BlueField-4 상에서 인프라 서비스를 일관된 방식으로 배포하고 운영할 수 있도록 설계되었습니다.

네트워킹, 보안, 스토리지, 관리 기능을 모두 DPU에 고정함으로써, Astra는 기존에 사용하던 DOCA 마이크로서비스와 운영 워크플로를 베어메탈 AI 시스템과 E-W 컴퓨트 패브릭 영역까지 자연스럽게 확장할 수 있게 합니다.

Astra 환경에서는 DOCA 마이크로서비스가 BlueField-4에서 직접 실행되며, DPU가 관리하는 제어 플레인을 통해 NVIDIA ConnectX-9 SuperNIC과 연동됩니다.

이 구조는 기존 DOCA 배포 환경과의 호환성을 유지하는 동시에, 멀티테넌트 베어메탈 AI 환경에 요구되는 더 강력한 격리와 제어 능력을 제공합니다. 특히 호스트 운영체제에 대한 새로운 의존성을 추가하지 않는다는 점이 큰 특징입니다.

BlueField Astra는 여러 DOCA 마이크로서비스를 통해 AI 시스템을 위한 인프라 제어 계층을 구성합니다.

네트워킹 영역에서는,

N-S(남북) 방향에서 DOCA Host-Based Networking(HBN)이 AI 클러스터의 프런트엔드에서 테넌트 인지형 프로비저닝, 격리, 정책 집행을 담당합니다.

E-W(동서) 방향에서는 DOCA 가속 Open vSwitch(OVS)가 소프트웨어 정의 네트워킹을 AI 컴퓨트 패브릭으로 확장하여, GPU 노드 간의 연결을 정밀하게 제어하면서도 패브릭 제어 자체는 테넌트 워크로드로부터 완전히 분리된 상태를 유지합니다.

보안 측면에서는,

DOCA Argus가 DPU에서 직접 인프라 수준의 텔레메트리와 런타임 가시성을 제공함으로써, 테넌트 신뢰 경계 바깥에서 모니터링과 정책 집행을 가능하게 합니다.

스토리지 영역에서는,

DOCA SNAP이 스토리지 서비스를 DPU로 오프로딩하여, 호스트 소프트웨어와 독립적으로 동작하는 안전하고 격리된 데이터 경로를 제공합니다.

관리 영역에서는,

DOCA DMS가 디바이스 탐색, 수명주기 관리, 보안 프로비저닝을 담당하며,

CSP가 AI 노드와 SuperNIC을 중앙 집중화된 DPU 기반 제어 지점을 통해 관리할 수 있도록 지원합니다.

이러한 DOCA 마이크로서비스들이 결합됨으로써, BlueField Astra는 N-S와 E-W 도메인 전반에 걸쳐 일관된 소프트웨어 정의 인프라 모델을 유지하면서도, 대규모 AI 워크로드가 요구하는 성능 특성은 그대로 보존할 수 있습니다.

AI 인프라의 미래를 안전하게 설계하다

AI 워크로드가 전례 없는 수준으로 확장됨에 따라, 서비스 제공자는 베어메탈 수준의 성능을 제공하는 동시에 엄격한 멀티테넌트 보안을 유지해야 하는 과제에 직면하고 있습니다. BlueField Astra를 통해 NVIDIA는 프런트엔드 네트워크에 국한되었던 신뢰 기반 제어를 AI 컴퓨트 패브릭 자체로까지 확장합니다.

BlueField DPU와 SuperNIC을 통합되고 격리된 단일 아키텍처 아래 결합함으로써, BlueField Astra는 CSP가 차세대 AI 인프라를 보다 확신을 가지고 설계하고, 프로비저닝하며, 안전하게 운영할 수 있도록 지원합니다. 이는 성능과 보안 중 어느 하나를 타협하는 방식이 아니라, 대규모 AI 환경을 전제로 한 인프라의 기본 구조 자체를 새롭게 정의하는 접근이라 할 수 있습니다.

-------------------------------

DPU(Data Processing Unit)는 데이터센터에서 네트워크·보안·스토리지·인프라 관리 같은 작업을

CPU 대신 전담 처리하도록 설계된 전용 프로세서입니다.

쉽게 말해, CPU가 하던 ‘인프라 운영 업무’를 떼어내어 맡기는 관리·제어 전용 두뇌입니다.

1️⃣ 왜 DPU가 등장했나

전통적인 서버 구조에서는 CPU가

- 애플리케이션 실행

- 네트워크 처리

- 보안 정책

- 스토리지 I/O

- 가상화 관리를 모두 담당했습니다.

AI·클라우드 환경에서는 이 방식이 성능 저하·보안 취약·운영 복잡성으로 이어졌습니다.

그래서 등장한 해법이 DPU입니다.

2️⃣ DPU의 핵심 역할

DPU는 다음과 같은 인프라 전용 기능을 처리합니다.

- 네트워킹: 패킷 처리, 가상 네트워크, N-S / E-W 트래픽 제어

- 보안: 방화벽, 암호화, 테넌트 격리, 제로 트러스트

- 스토리지: NVMe-oF, 스토리지 오프로딩

- 관리: 프로비저닝, 모니터링, 정책 집행

그 결과,

- CPU는 애플리케이션·AI 연산에 집중

- 인프라는 DPU가 책임지는 구조가 됩니다.

4️⃣ DPU의 가장 중요한 특징: 신뢰 경계

DPU는 **호스트 OS와 분리(out-of-band)**되어 동작합니다.

즉,

- 테넌트(사용자)는 DPU에 접근 불가

- 보안 정책과 네트워크 제어는 우회 불가능

- 베어메탈 서버에서도 클라우드급 보안 가능

이 점이 멀티테넌트 AI 데이터센터에서 결정적으로 중요합니다.

5️⃣ NVIDIA DPU의 예

대표적인 DPU는 **NVIDIA**의 BlueField 시리즈입니다.

- Arm CPU 코어 탑재

- 고성능 NIC 기능 통합

- DOCA 소프트웨어 스택 실행

- SuperNIC과 결합해 AI 패브릭 제어

이 구조 위에서 ICMS, BlueField Astra, 베어메탈 AI 멀티테넌시가 가능해집니다.

6️⃣ 한 문장 요약

DPU는 “AI 데이터센터의 관리자용 CPU”이며,

성능은 GPU가, 운영과 보안은 DPU가 책임지는 시대를 만든 핵심 칩입니다.

-----------------------------------

CSP(Cloud Service Provider) 관점에서 DPU가 필수인 이유는 한 문장으로 요약하면

“베어메탈 성능·멀티테넌트 보안·운영 자동화”를 동시에 만족시키는 유일한 제어 지점이기 때문입니다.

아래를 보면 왜 CPU나 NIC만으로는 한계가 있는지 분명해집니다.

1) 베어메탈 AI를 ‘상품’으로 만들기 위해

AI 고객은 가상화 오버헤드 없는 베어메탈 성능을 요구합니다.

하지만 베어메탈은 곧 보안·격리의 붕괴로 이어지기 쉽습니다.

DPU의 역할

- 제어 플레인을 호스트 OS에서 분리(out-of-band)

- 네트워크·보안 정책을 우회 불가로 강제

- 베어메탈에서도 클라우드급 멀티테넌시 제공

👉 DPU 없이는 베어메탈 AI를 안전한 상용 서비스로 제공하기 어렵습니다.

2) N-S와 E-W를 하나의 정책으로 묶기 위해

AI 클러스터는 **프런트엔드(N-S)**와 **GPU 간 패브릭(E-W)**이 동시에 중요합니다.

전통 구조에서는:

- N-S는 클라우드 보안 적용

- E-W는 성능 우선, 보안은 각 노드 의존 → 정책 불일치

DPU의 역할

- N-S와 E-W를 단일 신뢰 지점에서 통합 제어

- 정책을 NIC 하드웨어 단에서 직접 집행

- 횡적 이동(lateral movement) 차단

👉 대규모 AI 멀티테넌시의 핵심 조건입니다.

3) CPU를 ‘돈 버는 일’에만 쓰기 위해

CSP의 수익은 GPU/CPU를 얼마나 고객 워크로드에 집중시키느냐에 달려 있습니다.

DPU가 없을 때

- CPU가 네트워크, 암호화, 스토리지 I/O까지 담당

- 성능 저하 = 곧 비용 증가

DPU가 있을 때

- 인프라 작업을 전부 오프로딩

- CPU/GPU는 100% 고객 연산에 집중

👉 동일한 하드웨어로 더 많은 매출을 창출합니다.

4) 운영 자동화(OPEX)를 낮추기 위해

수천~수만 노드 AI 클러스터에서 수동 운영은 불가능합니다.

DPU 기반 운영의 장점

- 프로비저닝·정책·수명주기를 중앙에서 일괄 관리

- 장애 격리 범위 축소(노드 단위 → DPU 단위)

- 설정 드리프트 방지

👉 OPEX 절감 + 장애 확산 차단이라는 두 마리 토끼.

5) 규제·감사 요구에 대응하기 위해

금융·의료·국방·공공 AI는 **감사 가능성(auditability)**이 필수입니다.

DPU의 강점

- 정책과 로그가 호스트가 아닌 DPU에 상주

- 테넌트가 기록을 조작할 수 없음

- 규제 산업 요구에 맞는 명확한 신뢰 경계

👉 “보안은 옵션”이 아닌 기본 요건이 됩니다.

6) NVIDIA 생태계에서의 현실적인 이유

현재 대규모 AI 인프라는 NVIDIA GPU + SuperNIC + DPU 조합을 전제로 설계되고 있습니다.

- BlueField DPU: 제어·보안·관리

- ConnectX SuperNIC: 데이터 이동

- GPU: AI 연산

이 구조 위에서 ICMS, BlueField Astra, 베어메탈 멀티테넌시가 작동합니다.

CSP 입장에서는 표준을 거스르는 비용이 더 커집니다.

한 줄 요약 (CSP 관점)

DPU는 “AI 클라우드의 신뢰 앵커”다.

베어메탈 성능을 유지하면서도, 멀티테넌트 보안·운영 자동화·규제 대응을 동시에 가능하게 만드는 유일한 수단이다.

----------------------

“왜 DPU가 도입될수록 SSD 수요가 늘어나느냐?”

핵심 이유는 DPU가 ‘스토리지를 인프라 서비스로 만들면서’, SSD만이 그 역할을 감당할 수 있게 되기 때문입니다.

단계별로 설명하겠습니다.

1️⃣ DPU는 스토리지를 “CPU 부하”가 아닌 “독립 서비스”로 만든다

과거에는 스토리지 I/O가 호스트 CPU 의존이었습니다.

- 파일시스템

- NVMe 드라이버

- 암호화

- 멀티테넌트 격리

이 모든 것이 CPU 위에서 돌아갔습니다.

👉 DPU 도입 후

- 스토리지 경로가 DPU로 오프로딩

- CPU는 관여하지 않음

- 스토리지가 항상 켜져 있는 인프라 기능이 됨

이 구조에서 HDD는 latency·IOPS가 부족하고,

SSD만이 DPU 기반 오프로딩 모델과 호환됩니다.

2️⃣ DPU는 NVMe-oF / 분산 스토리지를 “기본값”으로 만든다

DPU는 NVMe-oF, 로컬 NVMe 풀링, disaggregated storage를 전제로 설계됩니다.

- DPU가 NVMe 큐 직접 제어

- 네트워크를 통해 SSD를 원격·로컬 가리지 않고 사용

- 스토리지 = 네트워크화된 리소스

👉 이때 HDD는 구조적으로 배제됩니다.

- 랜덤 I/O 불리

- 네트워크 경유 시 지연 폭증

결과적으로 **SSD 수요는 ‘선택’이 아니라 ‘전제조건’**이 됩니다.

3️⃣ 멀티테넌트 보안이 HDD를 밀어낸다

DPU의 가장 중요한 역할은 멀티테넌트 격리입니다.

- 테넌트별 I/O 격리

- 암호화 키 분리

- 접근 정책 하드웨어 집행

이 모든 것은 스토리지 I/O를 미세하게 쪼개서 제어해야 가능합니다.

👉 HDD는:

- 단일 디스크 공유 구조

- 테넌트 단위 제어 불리

👉 SSD는:

- 네임스페이스 분리

- 큐 단위 제어

- DPU와 1:1 매핑 가능

그래서 DPU 기반 보안 모델은 SSD를 강제합니다.

4️⃣ DPU는 “로컬 SSD”를 AI 서버의 기본 부품으로 만든다

DPU + GPU + SuperNIC 구조에서는

스토리지가 GPU 가까이 있어야 합니다.

- 체크포인트

- 데이터 캐시

- 모델 스냅샷

- 추론 warm cache

DPU가 이를 관리하면:

- 네트워크 왕복 감소

- GPU idle time 감소

- CPU 개입 제거

👉 결과적으로 AI 서버 1대당 SSD 탑재 용량이 증가합니다.

(“있으면 좋은 부품” → “없으면 성능 손실”)

5️⃣ DOCA SNAP: SSD 수요를 구조적으로 늘리는 트리거

NVIDIA의 DPU 생태계에서

BlueField + DOCA SNAP 조합은 결정적입니다.

- 스토리지 서비스가 DPU에서 상시 실행

- 호스트 OS와 무관

- SSD를 “네트워크 서비스”처럼 제공

👉 CSP 입장에서는:

- SSD를 많이 깔수록 서비스 상품화 가능

- HDD는 운영 자동화에 부적합

그래서 CAPEX 방향 자체가 SSD 중심으로 이동합니다.

6️⃣ 결과적으로 나타나는 변화

DPU 확산 → SSD 수요 증가의 연결 고리는 다음과 같습니다.

- DPU는 스토리지를 항상-on 인프라로 만듦

- 인프라 스토리지는 저지연·고IOPS 필수

- 멀티테넌트 격리는 SSD만 가능

- GPU 효율 극대화 = 로컬 NVMe SSD 필수

- 운영 자동화·보안 = HDD 탈락

한 문장 요약

DPU는 스토리지를 “관리 대상”이 아니라 “서비스 엔진”으로 바꾸며,

그 역할을 감당할 수 있는 유일한 매체가 SSD이기 때문에 SSD 수요가 구조적으로 증가한다.

'엔비디아-마이크로소프트-AMD-인텔' 카테고리의 다른 글

| 엔비디아 ICMS = Intelligent Compute Management System(2026.01.23) (1) | 2026.01.23 |

|---|---|

| 젠슨 황 “엔비디아, HBM4의 유일 사용자…H200 中 수출승인 막바지”(2026.01.07) (0) | 2026.01.07 |

| 2026CES 젠슨황 기조 연설(2026.01.06) (0) | 2026.01.06 |

| "엔비디아 사상 처음 있는 일"…젠슨 황 '29조' 쏟아부었다(2025.12.25) (0) | 2025.12.25 |

| "글로벌 반도체 매출 1000兆 시대"...삼성·SK하이닉스, 최대 수혜 본다(2025.12.15) (1) | 2025.12.15 |